شبكة عصبونية التفافية

| جزء من سلسلة عن |

| التعلم الآلي والتنقيب في البيانات |

|---|

في التعلم العميق، تعتبر الشبكة العصبونية الالتفافية Convolutional neural network (CNN أو ConvNet) هي فئة من الشبكات العصبونية العميقة، وهي الأكثر شيوعاً تطبيق لتحليل الصور المرئية.[1] تُعرف أيضاً باسم الانتقال الثابت أو الشبكات العصبونية الاصطناعية ثابتة الفضاء (SIANN)، استناداً إلى بنية الوزن المشترك لنواة الالتفاف أو المرشحات التي تنزلق إلى جانب ميزات الإدخال وتوفر استجابات مكافئة الترجمة\التحويل المعروفة باسم خرائط الميزات.[2][3] على عكس الحدس، فإن معظم الشبكات العصبونية الالتفافية هي فقط معادلة للترجمة\التحويل، على عكس الثابتة.[4]تمتلك تطبيقات في التعرف على الصور والفيديو، نظم التوصية،[5] تصنيف الصور، تقطيع الصور، تحليل الصور الطبية، معالجة اللغات الطبيعية،[6] واجهات الدماغ-حاسوب،[7]و المتسلسلات الزمنية المالية.[8]

شبكات CNN هي إصدارات منتظمة من پرسپترونات متعددة الطبقات. عادةً ما تعني الإدراك متعدد الطبقات شبكات متصلة تماماً، أي أن كل خلية عصبية في طبقة متصلة بجميع الخلايا العصبية في الطبقة التالية. "الاتصال الكامل" لهذه الشبكات يجعلها عرضة للبيانات بشكل زائد. تشمل الطرق النموذجية للتنظيم، أو منع الإفراط في التجهيز، ما يلي: تدريب الپارامترات أثناء التدريب (مثل تدهور\تراجع الوزن) أو قطع الاتصال (تم تخطي الاتصالات، والانسحاب، وما إلى ذلك) تتخذ شبكات CNN نهجاً مختلفاً تجاه التنظيم: فهي تستفيد من النمط الهرمي في البيانات وتجميع أنماط من التعقيد المتزايد باستخدام أنماط أصغر وأبسط منقوشة في مرشحاتها. لذلك، على نطاق الاتصال والتعقيد، تكون شبكات CNN في أقصى الحدود.

كانت الشبكات الالتفافية مستوحاة من عمليات علم الأحياء[9][10][11][12] من حيث أن نمط الاتصال بين الخلايا العصبية يشبه تنظيم القشرة البصرية للحيوان. يستجيب الأفراد العصبون القشري للمنبهات فقط في منطقة محدودة من المجال البصري المعروفة باسم المجال الاستقبالي. تتداخل المجالات الاستقبالية للخلايا العصبية المختلفة جزئياً بحيث تغطي المجال البصري بأكمله.

تستخدم شبكات CNN معالجة مسبقة قليلة نسبياً مقارنةً بـ خوارزميات تصنيف الصور. هذا يعني أن الشبكة تتعلم تحسين المرشحات (أو النواة) من خلال التعلم الآلي ،بينما في الخوارزميات التقليدية، يتم تصميم هذه المرشحات يدوية. هذا الاستقلال عن المعرفة السابقة والتدخل البشري في استخراج الميزات هو ميزة رئيسية.

تعريف

يشير اسم "الشبكة العصبونية الالتفافية" إلى أن الشبكة تستخدم عملية رياضية تسمى الالتفاف. الشبكات الالتفافية هي نوع متخصص من الشبكات العصبية التي تستخدم الالتفاف بدلاً من مضاعفة المصفوفة العامة في طبقة واحدة على الأقل من طبقاتها.[13]

البناء

قالب:Comparison image neural networks.svg

تتكون الشبكة العصبونية الالتفافية من طبقة إدخال، طبقات مخفية وطبقة إخراج. في أي شبكة عصبونية ذات نتائج\تغذية أمامية، تسمى أي طبقات وسطى بأنها مخفية لأن مدخلاتها ومخرجاتها محجوبة بتابع التنشيط و الالتفاف النهائي. في الشبكة العصبونية الالتفافية، تشتمل الطبقات المخفية على طبقات تؤدي التفافات. يشتمل هذا عادةً على طبقة تؤدي جداء نقطي لنواة الالتفاف مع مصفوفة إدخال الطبقة. عادةً ما يكون هذا الجداء هو جداء فوربينيوس الداخلي، وتابع التنشيط الخاص به هو عادةً ReLU. عندما تنزلق نواة الالتفاف على طول مصفوفة الإدخال للطبقة، فإن عملية الالتفاف تنشئ خريطة معالم\سمات، والتي بدورها تساهم في إدخال الطبقة التالية. يتبع ذلك طبقات أخرى مثل طبقات التجميع والطبقات المتصلة بالكامل وطبقات التسوية.

الطبقات الالتفافية

في CNN، يكون الإدخال عبارة عن موتر مع شكل: (عدد المدخلات) x (ارتفاع الإدخال) x (عرض الإدخال) x (إدخال تدرجات رمادية). بعد المرور عبر طبقة التفافية، تصبح الصورة مجردة لخريطة المعالم\السمات، وتسمى أيضاً خريطة التنشيط\التفعيل، بالشكل: (عدد المدخلات) × (ارتفاع خريطة المعالم\السمات) × (عرض خريطة المعالم\السمات) × (تدرجات رمادية لخريطة المعالم\السمات). تحتوي الطبقة الالتفافية داخل CNN بشكل عام على السمات التالية:

- المرشحات الالتفافية/النواة المحددة بالعرض والارتفاع (پارامترات فائقة).

- عدد قنوات الإدخال وقنوات الإخراج (الپارامترات الفائقة). يجب أن تساوي قنوات الإدخال لطبقة واحدة عدد قنوات الإخراج (وتسمى أيضاً العمق) لمدخلاتها.

- پارامترات إضافية لعملية الالتفاف، مثل: الحشو\التبطين، والخطوة\السير، والتمدد\التوسع.

تقوم الطبقات الالتفافية بلف المدخلات وتمرير نتيجتها إلى الطبقة التالية. هذا مشابه لاستجابة خلية عصبية في القشرة البصرية لمنبه معين.[14]تعالج كل خلية عصبية التفافية البيانات فقط من أجل المجال الحسي. على الرغم من أنه يمكن استخدام الشبكات العصبية المتصلة بالكامل لتعلم الميزات وتصنيف البيانات، إلا أن هذه البنية غير عملية بشكل عام للمدخلات الأكبر مثل الصور عالية الدقة. سيتطلب عدداً كبيراً جداً من الخلايا العصبية، حتى في بنية ضحلة، نظراً لحجم الإدخال الكبير للصور، حيث يمثل كل پكسل ميزة إدخال ذات صلة. على سبيل المثال، تحتوي الطبقة المتصلة بالكامل لصورة (صغيرة) بحجم 100 × 100 على 10000 أوزان لكل خلية عصبية في الطبقة الثانية. بدلاً من ذلك، يقلل الالتفاف من عدد الپارامترات الحرة، مما يسمح للشبكة بأن تكون أعمق.[15] على سبيل المثال، بغض النظر عن حجم الصورة، يتطلب استخدام منطقة تجانب 5 × 5، ولكل منها نفس الأوزان المشتركة، 25 پارامتر قابل للتعلم فقط. يؤدي استخدام أوزان منتظمة على عدد أقل من الپارامترات إلى تجنب التدرجات المتلاشية ومشاكل التدرجات المنبثقة التي لوحظت أثناء الانتشار الخلفي في الشبكات العصبونية التقليدية.[16][17]علاوة على ذلك ، تعتبر الشبكات العصبية التلافيفية مثالية للبيانات ذات البنية الشبيهة بالشبكة (مثل الصور) حيث يتم أخذ العلاقات المكانية بين الميزات المنفصلة في الاعتبار أثناء الالتفاف و / أو التجميع.

طبقات التجميع

قد تتضمن الشبكات الالتفافية طبقات تجميع محلية و / أو عالمية جنباً إلى جنب مع الطبقات الالتفافية التقليدية. تعمل طبقات التجميع على تقليل أبعاد البيانات من خلال دمج مخرجات مجموعات الخلايا العصبونية العنقودية في طبقة واحدة في خلية عصبية واحدة في الطبقة التالية. يجمع التجميع المحلي بين مجموعات صغيرة، وتستخدم أحجام التغطية مثل 2 × 2 بشكل شائع. يعمل التجميع الشامل على جميع الخلايا العصبية لخريطة المعالم.[18][19]هناك نوعان شائعان من التجميع في الاستخدام الشائع: الحد الأقصى والمتوسط. يستخدم الحد الأقصى لتجميع الحد الأقصى لقيمة كل مجموعة محلية من الخلايا العصبية في خريطة المعالم،[20][21] بينما يأخذ متوسط التجميع متوسط القيمة.

طبقات متصلة بالكامل

تربط الطبقات المتصلة بالكامل كل خلية عصبونية في طبقة واحدة بكل خلية عصبية في طبقة أخرى. إنها نفس الشبكة العصبونية ذات پرسپترون متعدد الطبقات التقليدية (MLP). تمر المصفوفة المسطحة عبر طبقة متصلة بالكامل لتصنيف الصور.

المجال الحسي

في الشبكات العصبونية، تتلقى كل خلية عصبية مدخلات من عدد من المواقع في الطبقة السابقة. في الطبقة الالتفافية، تتلقى كل خلية عصبية مدخلات من منطقة مقيدة فقط من الطبقة السابقة تسمى المجال الاستقبالي للخلايا العصبية. عادةً ما تكون المنطقة مربعة (على سبيل المثال، 5 × 5 خلايا عصبية). بينما، في طبقة متصلة بالكامل، يكون المجال المستقبِل هو الطبقة السابقة بأكملها. وهكذا، في كل طبقة التفافية، تأخذ كل خلية عصبية مدخلات من منطقة أكبر في الإدخال من الطبقات السابقة. ويرجع ذلك إلى تطبيق الالتفاف مراراً وتكراراً، والذي يأخذ في الاعتبار قيمة الپكسل، وكذلك وحدات الپكسل المحيطة به. عند استخدام طبقات dilated، يظل عدد وحدات الپكسل في المجال الحسي\الاستقبالي ثابتاً، ولكن المجال أقل كثافة حيث تنمو أبعاده عند الجمع بين تأثير طبقات متعددة.

الأوزان

تحسب كل خلية عصبية في الشبكة العصبونية قيمة الإخراج من خلال تطبيق تابع محدد على قيم الإدخال الواردة من الحقل الاستقبالي في الطبقة السابقة. يتم تحديد التابع الذي يتم تطبيقه على قيم الإدخال بواسطة متجه للأوزان والتحيز (عادةً الأرقام الحقيقية). يتكون التعلم من التعديل المتكرر لهذه التحيزات والأوزان.

يُطلق على متجه الأوزان والانحياز اسم المرشحات وتمثل ميزة معينة للإدخال (على سبيل المثال، شكل معين). السمة المميزة لشبكات CNN هي أن العديد من الخلايا العصبية يمكن أن تشترك في نفس المرشح. يقلل هذا من مساحة الذاكرة لأنه يتم استخدام تحيز فردي ومتجه واحد للأوزان عبر جميع المجالات المستقبلة التي تشترك في هذا المرشح، على عكس كل مجال حسي\مستقبل له تحيزه الخاص ووزن متجه.[22]

تاريخ

غالباً ما تتم مقارنة CNN بالطريقة التي يحقق بها الدماغ معالجة الرؤية في الكائنات الحية[23].[citation needed]

المجالات المستقبلة في القشرة البصرية

أظهر العمل الذي قام به هوبل و ڤيزل في الخمسينيات والستينيات من القرن الماضي أن القشرة البصرية للقطط تحتوي على خلايا عصبية بشكل فردي الاستجابة لمناطق صغيرة من المجال البصري. شريطة ألا تتحرك العينان، تُعرف منطقة المساحة البصرية التي تؤثر فيها المنبهات البصرية على إطلاق خلية عصبية واحدة باسم المجال المستقبل. [24]تحتوي الخلايا المجاورة على حقول استقبالية متشابهة ومتداخلة.[citation needed] ويختلف حجم وموقع الحقل المتلقي بشكل منهجي عبر القشرة لتشكيل خريطة كاملة للفضاء البصري.[citation needed] تمثل القشرة في كل نصف كرة الجانب المقابل للمجال البصري.[citation needed]

حددت ورقتهم لعام 1968 نوعين أساسيين من الخلايا البصرية في الدماغ:[10]

- الخلايا البسيطة، التي يتم تكبير ناتجها بواسطة حواف مستقيمة لها اتجاهات معينة داخل مجالها الاستقبالي

- الخلايا المعقدة، التي لها مجال حسي أكبر، والتي يكون ناتجها غير حساس للموقع الدقيق للحواف في المجال.

وقد اقترح كل من هوبل و ڤيزل أيضاً نموذجاً متتالياً لهذين النوعين من الخلايا لاستخدامه في مهام التعرف على الأنماط.[25][24]

نيوكوگنترون، أصل بنية CNN

تم تقديم "نيوكوگنترون"[9] بواسطة كونيهيكو فوكوشيما في عام 1980.[11][21][26] كان مستوحى من أعمال هوبل و ڤيزل المذكورة أعلاه. قدم نيوكوگنترون نوعين أساسيين من الطبقات في شبكات CNN: الطبقات الالتفافية وطبقات الاختزال. تحتوي الطبقة الالتفافية على وحدات تغطي مجالاتها الاستقبالية رقعة من الطبقة السابقة. غالباً ما يُطلق على متجه الوزن (مجموعة الپارامترات التكيفية) لمثل هذه الوحدة اسم مرشح. يمكن للوحدات مشاركة المرشحات. تحتوي طبقات الاختزال على وحدات تغطي مجالاتها الاستقبالية مناطقاً من طبقات التفافية سابقة. تحسب هذه الوحدة عادةً متوسط عمليات تنشيط الوحدات في التصحيح الخاص بها. يساعد هذا الاختزال في تصنيف الكائنات بشكل صحيح في المشاهد البصرية حتى عندما يتم إزاحة الكائنات.

في متغير من نيوكوگنترون يسمى كريسيسپترون، بدلاً من استخدام المتوسط المكاني لفوكوشيما، جاي ونگ وآخرون قدم طريقة تسمى التجميع الأقصى حيث تقوم وحدة الاختزال بحساب الحد الأقصى من عمليات التنشيط للوحدات في التصحيح الخاص بها.[27] غالباً ما يستخدم التجميع الأقصى في شبكات CNN الحديثة.[28]

تم اقتراح العديد من خوارزميات التعلم الخاضعة للإشراف وغير الخاضعة للإشراف على مدى عقود لتدريب أوزان نيوكوگنترون.[9] اليوم، ومع ذلك، يتم تدريب بنية CNN عادةً من خلال الانتشار الخلفي.

تعد نيوكوگنترون أول شبكة CNN تتطلب وحدات موجودة في مواقع متعددة على الشبكة لتشترك في الأوزان.

تم تقديم الشبكات العصبية التفافية في ورشة معالجة المعلومات العصبية في عام 1987، حيث قامت تلقائياً بتحليل الإشارات المتغيرة بمرور الوقت عن طريق استبدال الضرب\المضاعفة المكتسب بالالتفاف في الوقت المناسب، وعرضها للتعرف على الكلام.[29]

الشبكات العصبونية للتأخير الزمني

تم تقديم الشبكات العصبونية للتأخير الزمني (TDNN) في عام 1987 بواسطة أليكس وايبل وآخرون. وكانت أول شبكة التفافية، حيث حققت ثبات التحول.[30]لقد فعلت ذلك من خلال الاستفادة من تقاسم الوزن مع تدريب الانتشار الخلفي.[31]وهكذا، أثناء استخدام الهيكل الهرمي أيضاً كما هو الحال في نيوكوگنترون، فقد قام بإجراء تحسين شامل للأوزان بدلاً من الهيكل المحلي[30]

شبكات TDNN هي شبكات التفافية تشترك في الأوزان على طول البعد الزمني.[32] وهي تسمح بمعالجة إشارات الكلام على الدوام. في عام 1990، قدم هامپشر ووايبل متغيراً يؤدي التفافاً ثنائي الأبعاد.[33]نظراً لأن شبكات TDNN هذه تعمل على مخططات طيفية، فإن نظام التعرف على الصوت الناتج كان ثابتاً لكل من التحولات في الوقت والتردد. ألهم هذا التناظر الانتقالي في معالجة الصور باستخدام شبكات CNN.[31] يمكن أن يغطي تغطية مخرجات الخلايا العصبية المراحل الزمنية.[34]

تحقق شبكات TDNN الآن أفضل أداء في التعرف على الكلام عن بُعد.[35]

التجميع الأقصى

في عام 1990 ياماگوتشي وآخرون. قدم مفهوم التجميع الأقصى، وهو عملية تصفية ثابتة تحسب وتنشر القيمة القصوى لمنطقة معينة. لقد فعلوا ذلك من خلال الجمع بين TDNNs والتجميع الأقصى من أجل تحقيق نظام التعرف على الكلمات المعزول المستقل للمتحدث. [20] في نظامهم استخدموا عدة TDNNs لكل كلمة، واحد لكل مقطع لفظي. تم دمج نتائج كل TDNN عبر إشارة الإدخال باستخدام أقصى تجميع وتم بعد ذلك تمرير مخرجات طبقات التجميع إلى الشبكات التي تقوم بتصنيف الكلمات الفعلي.

التعرف على الصور مع شبكات CNN المدربة عن طريق الانحدار المتدرج

نظام للتعرف على الأرقام الرمز البريدي المكتوبة بخط اليد[36] تضمنت الالتفافات التي تم فيها تصميم معاملات النواة بعناية.[37]

استخدم يان لكن وآخرون. (1989)[37] الانتشار الخلفي لتعلم معاملات نواة الالتفاف مباشرة من صور الأرقام المكتوبة بخط اليد. وهكذا كان التعلم آلياً بالكامل، وكان أداؤه أفضل من تصميم المعامل اليدوي، وكان مناسباً لنطاق أوسع من مشاكل التعرف على الصور وأنواع الصور.

أصبح هذا النهج أساساً من أسس الرؤية الحاسوبية الحديثة.

LeNet-5

LeNet-5، شبكة التفافية رائدة من 7 مستويات بواسطة لكن وآخرون. في العام 1998،[38]الذي يصنف الأرقام، تم تطبيقه من قبل العديد من البنوك للتعرف على الأرقام المكتوبة بخط اليد على الشيكات (British English: cheques) الرقمية في صور 32 × 32 پكسل. تتطلب القدرة على معالجة الصور عالية الدقة طبقات أكبر وأكثر من الشبكات العصبية الالتفافية، لذلك فإن هذه التقنية مقيدة بتوافر موارد الحوسبة.

الشبكة العصبونية ذات الإزاحة الثابتة

وبالمثل، تم اقتراح إزاحة الشبكة العصبونية الثابتة من قبل دبليو. ژانگ وآخرون. للتعرف على شخصية الصورة في عام 1988.[2][3] وقد تم تعديل البنية وخوارزمية التدريب في عام 1991[39]وتم تطبيقها لمعالجة الصور الطبية[40] والاكتشاف التلقائي لسرطان الثدي في تصوير الثدي بالأشعة السينية.[41]

تم اقتراح تصميم مختلف قائم على الالتفاف في عام 1988[42] للتطبيق على تحلل الإشارات الالتفافية بـ تخطيط كهربائية العضل أحادية البعد عن طريق فك الالتفاف. تم تعديل هذا التصميم في عام 1989 إلى تصميمات أخرى قائمة على عدم الالتفاف.[43][44]

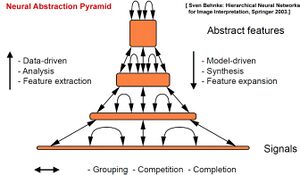

هرم التجريد العصبوني

تم تمديد بنية التغذية الأمامية للشبكات العصبونية الالتفافية في هرم التجريد العصبي[45] عن طريق اتصالات ذات تغذية عكسية راجعة وردود الفعل. تسمح الشبكة الالتفافية المتكررة الناتجة بالتضمين المرن للمعلومات السياقية لحل الغموض المحلي بشكل متكرر. على عكس النماذج السابقة، تم إنشاء مخرجات تشبه الصور بأعلى دقة، على سبيل المثال، للتجزئة الدلالية وإعادة بناء الصورة ومهام توطين الكائنات.

تطبيقات وحدة معالجة الرسومات

على الرغم من اختراع شبكات CNN في ثمانينيات القرن الماضي، إلا أن اختراقها في العقد الأول من القرن الحادي والعشرين تطلب عمليات تنفيذ سريعة على وحدة معالجة الرسومات (GPUs).

في عام 2004، أظهر كيه. إس. أو و كيه. ينگ أن الشبكات العصبية القياسية يمكن تسريعها بشكل كبير على وحدات معالجة الرسوميات. كان تنفيذها أسرع 20 مرة من تنفيذ مكافئ على وحدة المعالجة المركزية.[46][28] في عام 2005 ، أكدت ورقة أخرى أيضًا على قيمة GPGPU لـ التعلم الآلي.[47]

تم وصف أول تطبيق GPU لشبكة CNN في عام 2006 بواسطة كيه. تشلاپلا وآخرون. كان تنفيذها أسرع 4 مرات من تنفيذ مكافئ على وحدة المعالجة المركزية.[48]استخدم العمل اللاحق أيضاً وحدات معالجة الرسومات، في البداية لأنواع أخرى من الشبكات العصبية (تختلف عن شبكات CNN)، وخاصة الشبكات العصبونية غير الخاضعة للإشراف.[49][50][51][52]

في عام 2010، دان سيريسان وآخرون. في IDSIA أظهر أنه حتى الشبكات العصبية القياسية العميقة ذات الطبقات المتعددة يمكن تدريبها بسرعة على وحدة معالجة الرسومات من خلال التعلم الخاضع للإشراف من خلال الطريقة القديمة المعروفة باسم الانتشار الخلفي. تفوقت شبكتهم على أساليب التعلم الآلي السابقة في معيار [[قاعدة بيانات المعهد الوطني للمعايير والتكنولوجيا المعدلة |MNIST]] للأرقام المكتوبة بخط اليد.[53]في عام 2011، قاموا بتوسيع نهج GPU هذا ليشمل شبكات CNN، وحققوا عامل تسريع قدره 60، مع نتائج مبهرة.[18] في عام 2011، استخدموا شبكات CNN على وحدة معالجة الرسومات للفوز بمسابقة التعرف على الصور حيث حققوا أداءً فوق طاقة البشر لأول مرة.[54]بين 15 مايو 2011 و 30 سبتمبر 2012، فازت شبكات CNN الخاصة بهم بما لا يقل عن أربع مسابقات للصور.[55][28] في عام 2012، قاموا أيضاً بتحسين أفضل أداء في الأدبيات الخاصة بالصور المتعددة قاعدة البيانات، بما في ذلك قاعدة بيانات MNIST وقاعدة بيانات NORB ومجموعة بيانات HWDB1.0 (الأحرف الصينية) و [[ | CIFAR10 مجموعة بيانات CIFAR-10]] (مجموعة بيانات 60000 32 × 32 معنونة بـ صور RGB).[21]

في وقت لاحق، تعتمد CNN مماثلة على GPU بواسطة أليكس كريجڤسكي وآخرون. فاز في تحدي التعرف البصري واسع النطاق من إيمِج نت عام 2012.[56] فازت شبكة CNN العميقة للغاية مع أكثر من 100 طبقة بواسطة مايكروسوفت في مسابقة إيمِج نت عام 2015.[57]

تطبيقات إنتل زيون فاي

بالمقارنة مع تدريب شبكات CNN باستخدام GPU، لم يتم إيلاء الكثير من الاهتمام لـ المعالج المساعد إنتل زيون فاي.[58] التطور الملحوظ هو طريقة موازاة لتدريب الشبكات العصبونية الالتفافية على إنتل زيون فاي، المسمى هوگوايلد الخاضع للرقابة بترتيب عشوائي للتزامن (CHAOS).[59] يستغل CHAOS كلاً من التوازي على مستوى التسلسل و SIMD المتاح في إنتل زيون فاي.

السمات المميزة

في الماضي، تم استخدام نماذج الپرسپترون متعدد الطبقات (MLP) التقليدية للتعرف على الصور.[بحاجة لأمثلة] ومع ذلك، تسبب الاتصال الكامل بين العقد في curse of dimensionality، وكان مستعصية على الحل حسابياً مع صور ذات دقة أعلى. تحتوي الصورة 1000 × 1000 پكسل مع قنوات لون RGB على 3 ملايين وزن، وهي نسبة عالية جداً بحيث لا يمكن معالجتها بكفاءة على نطاق واسع مع اتصال كامل.

على سبيل المثال، في CIFAR-10، الصور بحجم 32 × 32 × 3 فقط (عرض 32، ارتفاع 32، 3 قنوات ملونة)، لذا فإن خلية عصبية واحدة متصلة بالكامل في الطبقة المخفية الأولى للشبكة العصبية العادية سيكون 32 * 32 * 3 = 3072 وزن. ومع ذلك، فإن صورة 200 × 200 ستؤدي إلى خلايا عصبية بها 200 * 200 * 3 = 120000 وزن.

أيضاً، لا تأخذ بنية الشبكة هذه في الاعتبار البنية المكانية للبيانات، وتعامل وحدات الپكسل التي تكون متباعدة تماماً مثل وحدات الپكسل القريبة من بعضها. هذا يتجاهل موضعية المرجع في البيانات ذات الهيكل الشبكي (مثل الصور)، سواء من الناحية الحسابية أو المعنوية. وبالتالي، فإن الاتصال الكامل للخلايا العصبية يكون هدراً لأغراض مثل التعرف على الصور التي تهيمن عليها أنماط الإدخال المحلية فراغياً.

الشبكات العصبية الالتفافية هي أشكال مختلفة من الإدراك الحسي متعدد الطبقات، مصممة لمحاكاة سلوك القشرة البصرية. تخفف هذه النماذج من التحديات التي تفرضها بنية MLP من خلال استغلال الارتباط المحلي المكاني القوي الموجود في الصور الطبيعية. على عكس MLPs، تتمتع CNN بالسمات المميزة التالية:

- مجلدات ثلاثية الأبعاد من الخلايا العصبية. طبقات CNN لها خلايا عصبية مرتبة في ثلاثة أبعاد: العرض والارتفاع والعمق.[60] حيث كل خلية عصبية داخل طبقة التفافية متصلة بمنطقة صغيرة فقط من الطبقة التي تسبقها، تسمى المجال الاستقبالي\الحسي. يتم تكديس أنواع مميزة من الطبقات، سواء محلياً أو متصلة تماماً، لتشكيل بنية CNN.

- الاتصال المحلي: باتباع مفهوم المجالات المستقبلة، تستغل شبكات CNN الموقع المكاني من خلال فرض نمط اتصال محلي بين الخلايا العصبية للطبقات المجاورة. وهكذا تضمن البنية أن " المرشحات" ينتج أقوى استجابة لنمط إدخال محلي مكانياً يؤدي تكديس العديد من هذه الطبقات إلى المرشحات اللا الخطية التي أصبحت عالمية بشكل متزايد (أي تستجيب لمنطقة أكبر من مساحة الپكسل) بحيث تنشئ الشبكة أولاً تمثيلات لأجزاء صغيرة من الإدخال، ثم تتجمع منها تمثيلات مناطق أكبر.

- الأوزان المشتركة: في شبكات CNN، يتم تكرار كل مرشح عبر المجال البصري بأكمله. تشترك هذه الوحدات المنسوخة في نفس المعلمات (متجه الوزن والتحيز) وتشكل خريطة معالم. هذا يعني أن جميع الخلايا العصبية في طبقة التفافية معينة تستجيب لنفس الميزة داخل مجال الاستجابة المحدد. تسمح وحدات النسخ المتماثل بهذه الطريقة بأن تكون خريطة التنشيط الناتجة متساوية في ظل تحولات مواقع ميزات الإدخال في المجال المرئي، أي أنها تمنح مكافئة تحويلية - بالنظر إلى أن طبقة لها خطوة واحدة.[61]

- التجميع: في طبقات التجميع الخاصة بشبكة CNN، يتم تقسيم خرائط المعالم إلى مناطق فرعية مستطيلة، ويتم تقسيم الميزات الموجودة في كل مستطيل بشكل مستقل إلى قيمة واحدة، عادةً عن طريق أخذ متوسطها أو الحد الأقصى لقيمتها. بالإضافة إلى تقليل أحجام خرائط الميزات، تمنح عملية التجميع درجة من الثبات الانتقالي للميزات الواردة فيها، مما يسمح لـ CNN بأن تكون أكثر قوة في مواجهة الاختلافات في مواقعها.[4]

تتيح هذه الخصائص معاً لشبكات CNN تحقيق تعميم أفضل على مشاكل الرؤية. يقلل تقاسم الوزن بشكل كبير من عدد الپارامترات الحرة التي تم تعلمها، وبالتالي تقليل متطلبات الذاكرة لتشغيل الشبكة والسماح بتدريب شبكات أكبر وأكثر قوة.

قوالب البناء

هذا القسم يحتاج المزيد من الأسانيد للتحقق. (June 2017) (Learn how and when to remove this template message) |

تتشكل بنية CNN من خلال كومة من الطبقات المميزة التي تحول حجم الإدخال إلى حجم إخراج (مثل الاحتفاظ بدرجات الفئة) من خلال وظيفة قابلة للتفاضل. يتم استخدام أنواع قليلة مميزة من الطبقات بشكل شائع. وتناقش هذه بمزيد من التفصيل أدناه.

الطبقة الالتفافية

الطبقة الالتفافية هي قالب البناء الأساسي لشبكة CNN. تتكون پارامترات الطبقة من مجموعة قابلة للتعلم المرشحات (أو النوى)، والتي لها مجال استقبال\حسي صغير، ولكنها تمتد عبر العمق الكامل لـ حجم الإدخال. أثناء التمرير الأمامي، يكون كل مرشح التفافي عبر عرض وارتفاع حجم الإدخال، وحساب الجداء النقطي بين إدخالات المرشح والمدخل، مما ينتج عنه خريطة التفعيل ثنائية الأبعاد لهذا المرشح. نتيجة لذلك، تتعرف الشبكة على المرشحات التي يتم تنشيطها عندما تكتشف نوعاً معيناً من الميزات في موضع مكاني معين في الإدخال.[62][nb 1]

يؤدي تكديس خرائط التنشيط\التفعيل لجميع المرشحات على طول بُعد العمق إلى تكوين حجم الإخراج الكامل لطبقة الالتفاف. وبالتالي يمكن أيضاً تفسير كل إدخال في حجم الإخراج على أنه ناتج من خلية عصبونية تنظر إلى منطقة صغيرة في الإدخال وتشارك الپارامترات مع الخلايا العصبونية في نفس خريطة التنشيط\التفعيل.

الاتصال المحلي

عند التعامل مع مدخلات عالية الأبعاد مثل الصور، من غير العملي توصيل الخلايا العصبية بجميع الخلايا العصبية في المجلد السابق لأن بنية الشبكة هذه لا تأخذ البنية المكانية للبيانات في الاعتبار. تستغل الشبكات الالتفافية الارتباط الفراغي عن طريق فرض نمط اتصال محلي متفرق بين الخلايا العصبية للطبقات المجاورة: كل خلية عصبية متصلة بمنطقة صغيرة فقط من حجم الإدخال.

مدى هذا الاتصال هو پارامتر فائق يسمى المجال الحسي للخلايا العصبية. الوصلات هي محلية في الفضاء (على طول العرض والارتفاع)، ولكنها تمتد دائماً على طول عمق حجم الإدخال بالكامل. تضمن مثل هذه البنية أن المرشحات التي تم تعلمها تنتج أقوى استجابة لنمط إدخال محلي مكانياً.

الترتيب الفراغي

تتحكم ثلاثة پارامترات فائقة في حجم إخراج الطبقة الالفافية: العمق، الخطوة وحجم الملء.

- يتحكم depth حجم الإخراج في عدد الخلايا العصبية في طبقة تتصل بنفس المنطقة من حجم الإدخال. تتعلم هذه الخلايا العصبية التنشيط لميزات مختلفة في الإدخال. على سبيل المثال، إذا كانت الطبقة الاتفافية الأولى تأخذ الصورة الأولية كمدخلات، فقد تنشط الخلايا العصبونية المختلفة على طول بُعد العمق في وجود حواف موجهة مختلفة، أو نقاط من اللون.

- تتحكم Stride في كيفية تخصيص عمق الأعمدة حول العرض والارتفاع. إذا كانت الخطوة 1، فإننا ننقل المرشحات بمقدار پكسل واحد في كل مرة. يؤدي هذا إلى تداخل بشكل كبير بين الحقول المستقبلة بين الأعمدة، وإلى أحجام الإخراج الكبيرة. لأي عدد صحيح تعني الخطوة S أن المرشح يترجم وحدات 'S' في المرة الواحدة لكل ناتج. من الناحية العملية ، يعد نادراً. تعني الخطوة الأكبر تداخلًا أصغر للحقول المستقبلة وأبعاداً فراغية أصغر لحجم الإخراج.[63]

- في بعض الأحيان، يكون من الملائم ملء الإدخال بالأصفار (أو قيم أخرى، مثل متوسط المنطقة) على حدود حجم الإدخال. حجم هذه الملء هو ثالث پارامتر تشعبية. يوفر الملء التحكم في الحجم الفراغي لحجم الإخراج. على وجه الخصوص، في بعض الأحيان يكون من المرغوب فيه الحفاظ بالضبط على الحجم الفراغي لحجم الإدخال، ويشار إلى هذا عادة باسم الملء "نفسه".

الحجم الفراغي لحجم الإخراج هو دالة لحجم حجم الإدخال ، حجم حقل النواة للخلايا العصبونية للطبقة الالتفافية، الخطوة ، ومقدار المساحة الصفرية على الحد. عدد الخلايا العصبونية التي "تناسب" حجم معين هو إذن:

إذا لم يكن هذا الرقم عدداً صحيحاً، فإن الخطوات غير صحيحة ولا يمكن تجانب الخلايا العصبية لتلائم حجم الإدخال بطريقة متماثلة. بشكل عام، تعيين ملء صفري لتكون عندما تكون الخطوة يضمن أن حجم الإدخال والإخراج الحجم سيكون له نفس الحجم فراغياً. ومع ذلك، ليس من الضروري دائماً استخدام جميع الخلايا العصبونية في الطبقة السابقة. على سبيل المثال، قد يقرر مصمم الشبكة العصبية استخدام جزء فقط من الملء.

تقاسم الپارامترات

يستخدم مخطط تقاسم الپارامترات في الطبقات الالتفافية للتحكم في عدد الپارامترات الحرة. وهو يعتمد على افتراض أنه إذا كانت ميزة التصحيح مفيدة للحساب في بعض المواقع المكانية، فيجب أن يكون من المفيد أيضاً الحساب في مواضع أخرى. بالإشارة إلى شريحة واحدة ثنائية الأبعاد من العمق على أنها "شريحة عمق"، فإن الخلايا العصبونية في كل شريحة عمق مقيدة باستخدام نفس الأوزان والانحياز.

نظراً لأن جميع الخلايا العصبونية في شريحة ذات عمق واحد تشترك في نفس الپارامترات، يمكن حساب الممر الأمامي في كل شريحة عمق للطبقة الالتفافية على أنها التفاف لأوزان الخلايا العصبونية مع حجم الإدخال.[nb 2] لذلك، من الشائع الإشارة إلى مجموعات الأوزان كمرشح (أو نواة)، والذي يتم لفه مع المدخلات. نتيجة هذا الالتفاف هي خريطة التفعيل، ويتم تجميع مجموعة خرائط التنشيط لكل مرشح مختلف معاً على طول بُعد العمق لإنتاج حجم الإخراج. تساهم مشاركة الپارامترات في ثبات التحويل لبنية CNN.[4]

في بعض الأحيان، قد لا يكون افتراض مشاركة الپارامتر منطقياً. هذا هو الحال بشكل خاص عندما يكون لصور الإدخال إلى CNN بنية مركزية محددة؛ التي نتوقع من أجلها ميزات مختلفة تماماً ليتم تعلمها في مواقع فراغية مختلفة. أحد الأمثلة العملية هو عندما تكون المدخلات عبارة عن وجوه تم توسيطها في الصورة: قد نتوقع تعلم ميزات مختلفة خاصة بالعين أو خاصة بالشعر في أجزاء مختلفة من الصورة. في هذه الحالة، من الشائع تخفيف نظام مشاركة الپارامترات، وبدلاً من ذلك ببساطة نسمي الطبقة "طبقة متصلة محلياً".

طبقة التجميع

مفهوم آخر مهم لشبكات CNN هو التجميع، وهو شكل من أشكال الاختزال اللاخطي. هناك العديد من التوابع غير الخطية لتنفيذ التجميع، حيث يكون الحد الأقصى للتجميع هو الأكثر شيوعاً. فهو يقسم صورة الإدخال في مجموعة من المستطيلات، ولكل منطقة فرعية من هذا القبيل، ينتج الحد الأقصى.

حدسياً، يكون الموقع الدقيق للميزة أقل أهمية من موقعه التقريبي بالنسبة إلى الميزات الأخرى. هذه هي الفكرة من وراء استخدام التجميع في الشبكات العصبونية الالتفافية. تعمل طبقة التجميع على تقليل الحجم الفراغي للتمثيل بشكل تدريجي، لتقليل عدد الپارامترات، مساحة الذاكرة ومقدار الحساب في الشبكة، وبالتالي التحكم أيضاً في الطفحان. يُعرف هذا بالاختزال من الشائع إدخال طبقة تجميع بشكل دوري بين الطبقات الالتفافية المتعاقبة (تتبع كل طبقة عادةً تابع التفعيل، مثل طبقة ReLU) في بنية CNN.[62] بينما تساهم طبقات التجميع في ثبات التحويل المحلي، فإنها لا توفر ثبات تحويل شامل في شبكة CNN، ما لم يتم استخدام شكل من أشكال التجميع الشامل.[4][61]تعمل طبقة التجميع عادةً بشكل مستقل على كل عمق أو شريحة من المدخلات وتغيير حجمها مكانياً. أحد الأشكال الشائعة جداً للتجميع الأقصى هو طبقة بها مرشحات بحجم 2 × 2، مطبقة بخطوة 2، والتي تقوم بتجميع كل شريحة عمق في الإدخال بمقدار 2 على طول كل من العرض والارتفاع، مع تجاهل 75٪ من التفعيلات:

بالإضافة إلى التجميع الأقصى، يمكن لوحدات التجميع استخدام وظائف أخرى، مثل متوسط التجميع أو تجميع ℓ2-norm. غالباً ما كان متوسط التجميع مستخدماً تاريخياً ولكنه تراجع مؤخراً عن الأفضلية مقارنةً بالتجميع الأقصى، والذي ينفذ عموماً بشكل أفضل في الممارسة.[64]

نظراً لتأثيرات الاختصار الفراغي السريع لحجم التمثيل،[which?] هناك اتجاه حديث نحو استخدام مرشحات أصغر[65] أو التخلص من طبقات التجميع كلياً.[66]

تجميع " منطقة الاهتمام" (المعروف أيضاً باسم تجميعRoI) هو أحد أشكال التجميع الأقصى، حيث يتم إصلاح حجم الإخراج ويكون مستطيل الإدخال عبارة عن پارامتر[67]

يعتبر التجميع مكوناً مهماً للشبكات العصبونية الالتفافية من أجل اكتشاف كائن استناداً إلى بنية R-CNN[68] .

طبقة ReLU

ReLU هو اختصار الوحدة الخطية المصححة، الذي يطبق تابع التفعيل الغير المشبع .[56]فهو يزيل القيم السلبية بشكل فعال من خريطة التفعيل عن طريق تعيينها إلى الصفر..[69]وقدم اللاخطية إلى تابع القرار وفي الشبكة العامة دون التأثير على المجالات الاستقبالية\الحسية لطبقات الالتفاف.

يمكن أيضاً استخدام توابع أخرى لزيادة اللاخطية، على سبيل المثال دالة الظل الزائدية المشبعة, , دالة السينية . غالباً ما يُفضل ReLU على التوابع الأخرى لأنه يدرب الشبكة العصبية أسرع عدة مرات دون عقوبة كبيرة على دقة التعميم.[70]

طبقة متصلة بالكامل

بعد عدة طبقات التفافية وتجميع قصوى، يتم التصنيف النهائي عبر طبقات متصلة بالكامل. الخلايا العصبونية الموجودة في طبقة متصلة بالكامل لها اتصالات بجميع عمليات التفعيل في الطبقة السابقة، كما يظهر في شبكات عصبونية اصطناعية العادية (غير التفافية). وبالتالي يمكن حساب عمليات تفعيلها على أنها تحويل تآلفي، مع ضرب المصفوفات متبوعاً بتعويض الانحياز (إضافة متجه لمصطلح انحياز مكتسب أو ثابت).[citation needed]

طبقة الضياعات

تحدد "طبقة الضياعات" أو "تابع الضياعات" كيف يصحح التدريب الانحراف بين الناتج المتوقع للشبكة وتسميات البيانات الصحيحة (أثناء التعلم الخاضع للإشراف ). يمكن استخدام تابع الضياعات المختلف، اعتماداً على التوابع المحددة.

تُستخدم دالة الضياعات سوفت ماكس للتنبؤ بفئة واحدة من الفئات الحصرية المتبادلة "K".[nb 3]تستخدم إنتروپية متقاطعة سينية الضياعات للتنبؤ بقيم احتمالية مستقلة لـ K في . تُستخدم الضياعات الإقليدية من أجل الانحدار إلى القيمة الحقيقية .

اختيار الپارامترات الفائقة

هذا القسم يحتاج المزيد من الأسانيد للتحقق. (June 2017) (Learn how and when to remove this template message) |

تستخدم شبكات CNN المزيد من الپارامترات الفائقة مقارنةً بمعيار متعدد الطبقات قياسي (MLP). بينما لا تزال القواعد المعتادة لثوابت معدلات التعلم و التنظيم سارية، ويجب مراعاة ما يلي عند التحسين.

عدد المرشحات

نظراً لأن حجم خريطة المعالم\الميزات يتناقص مع العمق، تميل الطبقات القريبة من طبقة الإدخال إلى عدد أقل من المرشحات بينما يمكن أن تحتوي الطبقات الأعلى على المزيد. لموازنة الحساب في كل طبقة، يتم الاحتفاظ بمنتج قيم الميزات va بموضع الپكسل ثابتاً تقريباً عبر الطبقات. يتطلب الاحتفاظ بمزيد من المعلومات حول الإدخال الحفاظ على العدد الإجمالي لعمليات التفعيل (عدد خرائط الميزات مضروباً في عدد مواضع الپكسل) غير متناقص من طبقة إلى أخرى.

يتحكم عدد خرائط الميزات بشكل مباشر في السعة ويعتمد على عدد الأمثلة المتاحة وتعقيد المهام.

حجم المرشح

تختلف أحجام المرشحات الشائعة الموجودة في الأدبيات اختلافاً كبيراً، وعادةً ما يتم اختيارها بناءً على مجموعة البيانات.

يتمثل التحدي في العثور على المستوى الصحيح من التفصيل من أجل إنشاء تجريدات بالمقياس المناسب، بالنظر إلى مجموعة بيانات معينة، وبدون طفحان.

نوع التجميع وحجمه

في شبكات CNN الحديثة، عادةً ما يتم استخدام التجميع الأقصى، وغالباً ما يكون بحجم 2 × 2، بخطوة 2. وهذا يعني أن الإدخال تم اختزاله بشكل كبير، مما يؤدي إلى زيادة تحسين الكفاءة الحسابية.

قد تضمن أحجام المدخلات الكبيرة جداً تجميع 4 × 4 في الطبقات السفلية.[71] ومع ذلك، فإن اختيار الأشكال الأكبر سيؤدي بشكل كبير إلى تقليل البعد للإشارة، وقد يؤدي إلى زيادة فقدان المعلومات. غالباً ما يكون أداء نوافذ التجميع غير المتداخلة أفضل.[64]

معادلة التحويل

يُفترض عموماً أن شبكات CNN ثابتة في تحولات المدخلات. ومع ذلك، فإن طبقات الالتفاف أو التجميع داخل CNN التي لا تحتوي على خطوة أكبر من واحدة هي مكافئة، على عكس الثابتة، لتحويلات المدخلات.[61] تتجاهل الطبقات التي تحتوي على خطوة أكبر من واحدة مبرهنة استعيان نايكوست-شانون، وتؤدي إلى تعرج إشارة الإدخال، مما يكسر خاصية التكافؤ (يشار إليها أيضاً باسم التغاير). [61]علاوة على ذلك، إذا استخدمت CNN طبقات متصلة بالكامل، فإن معادلة التحويل لا تعني ثبات التحويل، مثل الطبقات المتصلة بالكامل ليست ثابتة لتحولات المدخلات.[72][4] يتمثل أحد الحلول لثبات التحويل الكامل في تجنب أي اختزال في جميع أنحاء الشبكة وتطبيق متوسط التجميع العالمي في الطبقة الأخيرة.[61]بالإضافة إلى ذلك، تم اقتراح العديد من الحلول الجزئية الأخرى، مثل مانع التعرج،[73] شبكات المحولات الفراغية،[74]تعزيز البيانات، الاختزال مع التجميع، [4] و الشبكات العصبونية الكبسولية.[75]

Regularization methods

هذا القسم يحتاج المزيد من الأسانيد للتحقق. (June 2017) (Learn how and when to remove this template message) |

التنظيم هو عملية إدخال معلومات إضافية لحل مسألة مطروحة جيداً أو لمنع الطفحان. تستخدم شبكات CNN أنواعاً مختلفة من التنظيم.

تجريبياً

التخفيف

نظراً لأن الطبقة المتصلة بالكامل تشغل معظم الپارامترات، فهي عرضة للطفحان. إحدى الطرق لتقليل فرط التخصيص هي التخفيف.[76][77] في كل مرحلة تدريب، يتم إما "استبعاد" العقد الفردية من الشبكة (يتم تجاهلها) باحتمال أو يتم الاحتفاظ بها مع الاحتمال ، بحيث تكون الشبكة مغادرة الشبكة المخفضة؛ يتم أيضاً إزالة الحواف الواردة والصادرة للعقدة المخففة. يتم تدريب الشبكة المصغرة فقط على البيانات في تلك المرحلة. يتم بعد ذلك إعادة إدخال العقد التي تم إزالتها في الشبكة بأوزانها الأصلية.

في مراحل التدريب، عادةً ما تكون قيمة 0.5؛ بالنسبة لعقد الإدخال، يكون عادةً أعلى من ذلك بكثير لأن المعلومات تُفقد مباشرةً عند تجاهل عقد الإدخال.

في وقت الاختبار بعد انتهاء التدريب، نود بشكل مثالي العثور على متوسط عينة لجميع الشبكات الممكنة التي تم استبعادها؛ للأسف، هذا غير ممكن للقيم الكبيرة لـ . ومع ذلك، يمكننا إيجاد تقدير تقريبي باستخدام الشبكة الكاملة مع ترجيح ناتج كل عقدة بعامل ، وبالتالي فإن القيمة المتوقعة لإخراج أي عقدة هي نفسها كما في مراحل التدريب. هذه هي أكبر مساهمة لطريقة التسرب: على الرغم من أنها تولد شبكات عصبية بشكل فعال، وعلى هذا النحو يسمح بدمج النماذج، في وقت الاختبار لا يلزم اختبار سوى شبكة واحدة.

من خلال تجنب تدريب جميع العقد على جميع بيانات التدريب، يقلل التسرب من التجهيز الزائد. تعمل الطريقة أيضاً على تحسين سرعة التدريب بشكل كبير. هذا يجعل تركيبة النموذج عملية، حتى مع الشبكة لعصبونية العميقة. يبدو أن هذه التقنية تقلل من تفاعلات العقد، مما يؤدي بهم إلى تعلم المزيد من الميزات القوية [مطلوب توضيح] التي تعمم بشكل أفضل على البيانات الجديدة.

DropConnect

DropConnect هو تعميم للتخفيف حيث يمكن إسقاط كل اتصال، بدلاً من كل وحدة إخراج، مع احتمال . وبالتالي تتلقى كل وحدة مدخلات من مجموعة فرعية عشوائية من الوحدات في الطبقة السابقة.[78]

يشبه DropConnect التخفيف لأنه يقدم تبايناً ديناميكياً داخل النموذج، ولكنه يختلف في أن التباين موجود على الأوزان، بدلاً من متجهات الإخراج للطبقة. بمعنى آخر، تصبح الطبقة المتصلة بالكامل مع DropConnect طبقة متصلة بشكل ضئيل يتم فيها اختيار الروابط عشوائياً أثناء مرحلة التدريب.

Stochastic pooling

A major drawback to Dropout is that it does not have the same benefits for convolutional layers, where the neurons are not fully connected.

In stochastic pooling,[79] the conventional deterministic pooling operations are replaced with a stochastic procedure, where the activation within each pooling region is picked randomly according to a multinomial distribution, given by the activities within the pooling region. This approach is free of hyperparameters and can be combined with other regularization approaches, such as dropout and data augmentation.

An alternate view of stochastic pooling is that it is equivalent to standard max pooling but with many copies of an input image, each having small local deformations. This is similar to explicit elastic deformations of the input images,[80] which delivers excellent performance on the MNIST data set.[80] Using stochastic pooling in a multilayer model gives an exponential number of deformations since the selections in higher layers are independent of those below.

Artificial data

Because the degree of model overfitting is determined by both its power and the amount of training it receives, providing a convolutional network with more training examples can reduce overfitting. Because these networks are usually trained with all available data, one approach is to either generate new data from scratch (if possible) or perturb existing data to create new ones. For example, input images could be asymmetrically cropped by a few percent to create new examples with the same label as the original.[81]

Explicit

Early stopping

One of the simplest methods to prevent overfitting of a network is to simply stop the training before overfitting has had a chance to occur. It comes with the disadvantage that the learning process is halted.

Number of parameters

Another simple way to prevent overfitting is to limit the number of parameters, typically by limiting the number of hidden units in each layer or limiting network depth. For convolutional networks, the filter size also affects the number of parameters. Limiting the number of parameters restricts the predictive power of the network directly, reducing the complexity of the function that it can perform on the data, and thus limits the amount of overfitting. This is equivalent to a "zero norm".

Weight decay

A simple form of added regularizer is weight decay, which simply adds an additional error, proportional to the sum of weights (L1 norm) or squared magnitude (L2 norm) of the weight vector, to the error at each node. The level of acceptable model complexity can be reduced by increasing the proportionality constant('alpha' hyperparameter), thus increasing the penalty for large weight vectors.

L2 regularization is the most common form of regularization. It can be implemented by penalizing the squared magnitude of all parameters directly in the objective. The L2 regularization has the intuitive interpretation of heavily penalizing peaky weight vectors and preferring diffuse weight vectors. Due to multiplicative interactions between weights and inputs this has the useful property of encouraging the network to use all of its inputs a little rather than some of its inputs a lot.

L1 regularization is also common. It makes the weight vectors sparse during optimization. In other words, neurons with L1 regularization end up using only a sparse subset of their most important inputs and become nearly invariant to the noisy inputs. L1 with L2 regularization can be combined; this is called Elastic net regularization.

Max norm constraints

Another form of regularization is to enforce an absolute upper bound on the magnitude of the weight vector for every neuron and use projected gradient descent to enforce the constraint. In practice, this corresponds to performing the parameter update as normal, and then enforcing the constraint by clamping the weight vector of every neuron to satisfy . Typical values of are order of 3–4. Some papers report improvements[82] when using this form of regularization.

Hierarchical coordinate frames

Pooling loses the precise spatial relationships between high-level parts (such as nose and mouth in a face image). These relationships are needed for identity recognition. Overlapping the pools so that each feature occurs in multiple pools, helps retain the information. Translation alone cannot extrapolate the understanding of geometric relationships to a radically new viewpoint, such as a different orientation or scale. On the other hand, people are very good at extrapolating; after seeing a new shape once they can recognize it from a different viewpoint.[83]

An earlier common way to deal with this problem is to train the network on transformed data in different orientations, scales, lighting, etc. so that the network can cope with these variations. This is computationally intensive for large data-sets. The alternative is to use a hierarchy of coordinate frames and use a group of neurons to represent a conjunction of the shape of the feature and its pose relative to the retina. The pose relative to the retina is the relationship between the coordinate frame of the retina and the intrinsic features' coordinate frame.[84]

Thus, one way to represent something is to embed the coordinate frame within it. This allows large features to be recognized by using the consistency of the poses of their parts (e.g. nose and mouth poses make a consistent prediction of the pose of the whole face). This approach ensures that the higher-level entity (e.g. face) is present when the lower-level (e.g. nose and mouth) agree on its prediction of the pose. The vectors of neuronal activity that represent pose ("pose vectors") allow spatial transformations modeled as linear operations that make it easier for the network to learn the hierarchy of visual entities and generalize across viewpoints. This is similar to the way the human visual system imposes coordinate frames in order to represent shapes.[85]

Applications

Image recognition

CNNs are often used in image recognition systems. In 2012 an error rate of 0.23% on the MNIST database was reported.[21] Another paper on using CNN for image classification reported that the learning process was "surprisingly fast"; in the same paper, the best published results as of 2011 were achieved in the MNIST database and the NORB database.[18] Subsequently, a similar CNN called AlexNet[86] won the ImageNet Large Scale Visual Recognition Challenge 2012.

When applied to facial recognition, CNNs achieved a large decrease in error rate.[87] Another paper reported a 97.6% recognition rate on "5,600 still images of more than 10 subjects".[12] CNNs were used to assess video quality in an objective way after manual training; the resulting system had a very low root mean square error.[34]

The ImageNet Large Scale Visual Recognition Challenge is a benchmark in object classification and detection, with millions of images and hundreds of object classes. In the ILSVRC 2014,[88] a large-scale visual recognition challenge, almost every highly ranked team used CNN as their basic framework. The winner GoogLeNet[89] (the foundation of DeepDream) increased the mean average precision of object detection to 0.439329, and reduced classification error to 0.06656, the best result to date. Its network applied more than 30 layers. That performance of convolutional neural networks on the ImageNet tests was close to that of humans.[90] The best algorithms still struggle with objects that are small or thin, such as a small ant on a stem of a flower or a person holding a quill in their hand. They also have trouble with images that have been distorted with filters, an increasingly common phenomenon with modern digital cameras. By contrast, those kinds of images rarely trouble humans. Humans, however, tend to have trouble with other issues. For example, they are not good at classifying objects into fine-grained categories such as the particular breed of dog or species of bird, whereas convolutional neural networks handle this.[citation needed]

In 2015 a many-layered CNN demonstrated the ability to spot faces from a wide range of angles, including upside down, even when partially occluded, with competitive performance. The network was trained on a database of 200,000 images that included faces at various angles and orientations and a further 20 million images without faces. They used batches of 128 images over 50,000 iterations.[91]

Video analysis

Compared to image data domains, there is relatively little work on applying CNNs to video classification. Video is more complex than images since it has another (temporal) dimension. However, some extensions of CNNs into the video domain have been explored. One approach is to treat space and time as equivalent dimensions of the input and perform convolutions in both time and space.[92][93] Another way is to fuse the features of two convolutional neural networks, one for the spatial and one for the temporal stream.[94][95][96] Long short-term memory (LSTM) recurrent units are typically incorporated after the CNN to account for inter-frame or inter-clip dependencies.[97][98] Unsupervised learning schemes for training spatio-temporal features have been introduced, based on Convolutional Gated Restricted Boltzmann Machines[99] and Independent Subspace Analysis.[100]

Natural language processing

CNNs have also been explored for natural language processing. CNN models are effective for various NLP problems and achieved excellent results in semantic parsing,[101] search query retrieval,[102] sentence modeling,[103] classification,[104] prediction[105] and other traditional NLP tasks.[106]

Anomaly Detection

A CNN with 1-D convolutions was used on time series in the frequency domain (spectral residual) by an unsupervised model to detect anomalies in the time domain.[107]

Drug discovery

CNNs have been used in drug discovery. Predicting the interaction between molecules and biological proteins can identify potential treatments. In 2015, Atomwise introduced AtomNet, the first deep learning neural network for structure-based rational drug design.[108] The system trains directly on 3-dimensional representations of chemical interactions. Similar to how image recognition networks learn to compose smaller, spatially proximate features into larger, complex structures,[109] AtomNet discovers chemical features, such as aromaticity, sp3 carbons and hydrogen bonding. Subsequently, AtomNet was used to predict novel candidate biomolecules for multiple disease targets, most notably treatments for the Ebola virus[110] and multiple sclerosis.[111]

Health risk assessment and biomarkers of aging discovery

CNNs can be naturally tailored to analyze a sufficiently large collection of time series data representing one-week-long human physical activity streams augmented by the rich clinical data (including the death register, as provided by, e.g., the NHANES study). A simple CNN was combined with Cox-Gompertz proportional hazards model and used to produce a proof-of-concept example of digital biomarkers of aging in the form of all-causes-mortality predictor.[112]

Checkers game

CNNs have been used in the game of checkers. From 1999 to 2001, Fogel and Chellapilla published papers showing how a convolutional neural network could learn to play checker using co-evolution. The learning process did not use prior human professional games, but rather focused on a minimal set of information contained in the checkerboard: the location and type of pieces, and the difference in number of pieces between the two sides. Ultimately, the program (Blondie24) was tested on 165 games against players and ranked in the highest 0.4%.[113][114] It also earned a win against the program Chinook at its "expert" level of play.[115]

Go

CNNs have been used in computer Go. In December 2014, Clark and Storkey published a paper showing that a CNN trained by supervised learning from a database of human professional games could outperform GNU Go and win some games against Monte Carlo tree search Fuego 1.1 in a fraction of the time it took Fuego to play.[116] Later it was announced that a large 12-layer convolutional neural network had correctly predicted the professional move in 55% of positions, equalling the accuracy of a 6 dan human player. When the trained convolutional network was used directly to play games of Go, without any search, it beat the traditional search program GNU Go in 97% of games, and matched the performance of the Monte Carlo tree search program Fuego simulating ten thousand playouts (about a million positions) per move.[117]

A couple of CNNs for choosing moves to try ("policy network") and evaluating positions ("value network") driving MCTS were used by AlphaGo, the first to beat the best human player at the time.[118]

Time series forecasting

Recurrent neural networks are generally considered the best neural network architectures for time series forecasting (and sequence modeling in general), but recent studies show that convolutional networks can perform comparably or even better.[119][8] Dilated convolutions[120] might enable one-dimensional convolutional neural networks to effectively learn time series dependences.[121] Convolutions can be implemented more efficiently than RNN-based solutions, and they do not suffer from vanishing (or exploding) gradients.[122] Convolutional networks can provide an improved forecasting performance when there are multiple similar time series to learn from.[123] CNNs can also be applied to further tasks in time series analysis (e.g., time series classification[124] or quantile forecasting[125]).

Cultural Heritage and 3D-datasets

As archaeological findings like clay tablets with cuneiform writing are increasingly acquired using 3D scanners first benchmark datasets are becoming available like HeiCuBeDa[126] providing almost 2.000 normalized 2D- and 3D-datasets prepared with the GigaMesh Software Framework.[127] So curvature based measures are used in conjunction with Geometric Neural Networks (GNNs) e.g. for period classification of those clay tablets being among the oldest documents of human history.[128][129]

Fine-tuning

For many applications, the training data is less available. Convolutional neural networks usually require a large amount of training data in order to avoid overfitting. A common technique is to train the network on a larger data set from a related domain. Once the network parameters have converged an additional training step is performed using the in-domain data to fine-tune the network weights, this is known as transfer learning. Furthermore, this technique allows convolutional network architectures to successfully be applied to problems with tiny training sets.[130]

Human interpretable explanations

End-to-end training and prediction are common practice in computer vision. However, human interpretable explanations are required for critical systems such as a self-driving cars.[131] With recent advances in visual salience, spatial and temporal attention, the most critical spatial regions/temporal instants could be visualized to justify the CNN predictions.[132][133]

Related architectures

Deep Q-networks

A deep Q-network (DQN) is a type of deep learning model that combines a deep neural network with Q-learning, a form of reinforcement learning. Unlike earlier reinforcement learning agents, DQNs that utilize CNNs can learn directly from high-dimensional sensory inputs via reinforcement learning.[134]

Preliminary results were presented in 2014, with an accompanying paper in February 2015.[135] The research described an application to Atari 2600 gaming. Other deep reinforcement learning models preceded it.[136]

Deep belief networks

Convolutional deep belief networks (CDBN) have structure very similar to convolutional neural networks and are trained similarly to deep belief networks. Therefore, they exploit the 2D structure of images, like CNNs do, and make use of pre-training like deep belief networks. They provide a generic structure that can be used in many image and signal processing tasks. Benchmark results on standard image datasets like CIFAR[137] have been obtained using CDBNs.[138]

Notable libraries

- Caffe: A library for convolutional neural networks. Created by the Berkeley Vision and Learning Center (BVLC). It supports both CPU and GPU. Developed in C++, and has Python and MATLAB wrappers.

- Deeplearning4j: Deep learning in Java and Scala on multi-GPU-enabled Spark. A general-purpose deep learning library for the JVM production stack running on a C++ scientific computing engine. Allows the creation of custom layers. Integrates with Hadoop and Kafka.

- Dlib: A toolkit for making real world machine learning and data analysis applications in C++.

- Microsoft Cognitive Toolkit: A deep learning toolkit written by Microsoft with several unique features enhancing scalability over multiple nodes. It supports full-fledged interfaces for training in C++ and Python and with additional support for model inference in C# and Java.

- TensorFlow: Apache 2.0-licensed Theano-like library with support for CPU, GPU, Google's proprietary tensor processing unit (TPU),[139] and mobile devices.

- Theano: The reference deep-learning library for Python with an API largely compatible with the popular NumPy library. Allows user to write symbolic mathematical expressions, then automatically generates their derivatives, saving the user from having to code gradients or backpropagation. These symbolic expressions are automatically compiled to CUDA code for a fast, on-the-GPU implementation.

- Torch: A scientific computing framework with wide support for machine learning algorithms, written in C and Lua. The main author is Ronan Collobert, and it is now used at Facebook AI Research and Twitter.

Notable APIs

- Keras: A high level API written in Python for TensorFlow and Theano convolutional neural networks.[140]

انظر أيضاً

- Attention (machine learning)

- Convolution

- Deep learning

- Natural-language processing

- Neocognitron

- Scale-invariant feature transform

- Time delay neural network

- Vision processing unit

Notes

- ^ عند تطبيقه على أنواع أخرى من البيانات غير بيانات الصورة، مثل بيانات الصوت، قد يتوافق "الموضع الفراغي" بشكل مختلف مع نقاط مختلفة في المجال الزمني، مجال التردد أو فضاءات رياضية.

- ^ hence the name "convolutional layer"

- ^ So-called categorical data.

References

- ^ Valueva, M.V.; Nagornov, N.N.; Lyakhov, P.A.; Valuev, G.V.; Chervyakov, N.I. (2020). "Application of the residue number system to reduce hardware costs of the convolutional neural network implementation". Mathematics and Computers in Simulation. Elsevier BV. 177: 232–243. doi:10.1016/j.matcom.2020.04.031. ISSN 0378-4754.

Convolutional neural networks are a promising tool for solving the problem of pattern recognition.

- ^ أ ب Zhang, Wei (1988). "Shift-invariant pattern recognition neural network and its optical architecture". Proceedings of Annual Conference of the Japan Society of Applied Physics.

- ^ أ ب Zhang, Wei (1990). "Parallel distributed processing model with local space-invariant interconnections and its optical architecture". Applied Optics. 29 (32): 4790–7. Bibcode:1990ApOpt..29.4790Z. doi:10.1364/AO.29.004790. PMID 20577468.

- ^ أ ب ت ث ج ح Mouton, Coenraad; Myburgh, Johannes C.; Davel, Marelie H. (2020). Gerber, Aurona (ed.). "Stride and Translation Invariance in CNNs". Artificial Intelligence Research. Communications in Computer and Information Science (in الإنجليزية). Cham: Springer International Publishing. 1342: 267–281. arXiv:2103.10097. doi:10.1007/978-3-030-66151-9_17. ISBN 978-3-030-66151-9. S2CID 232269854.

- ^ van den Oord, Aaron; Dieleman, Sander; Schrauwen, Benjamin (2013-01-01). Burges, C. J. C.; Bottou, L.; Welling, M.; Ghahramani, Z.; Weinberger, K. Q. (eds.). Deep content-based music recommendation (PDF). Curran Associates, Inc. pp. 2643–2651.

- ^ Collobert, Ronan; Weston, Jason (2008-01-01). A Unified Architecture for Natural Language Processing: Deep Neural Networks with Multitask Learning. ICML '08. New York, NY, USA: ACM. pp. 160–167. doi:10.1145/1390156.1390177. ISBN 978-1-60558-205-4. S2CID 2617020.

{{cite book}}:|journal=ignored (help) - ^ Avilov, Oleksii; Rimbert, Sebastien; Popov, Anton; Bougrain, Laurent (July 2020). "Deep Learning Techniques to Improve Intraoperative Awareness Detection from Electroencephalographic Signals". 2020 42nd Annual International Conference of the IEEE Engineering in Medicine & Biology Society (EMBC). Montreal, QC, Canada: IEEE. 2020: 142–145. doi:10.1109/EMBC44109.2020.9176228. ISBN 978-1-7281-1990-8. PMID 33017950. S2CID 221386616.

- ^ أ ب Tsantekidis, Avraam; Passalis, Nikolaos; Tefas, Anastasios; Kanniainen, Juho; Gabbouj, Moncef; Iosifidis, Alexandros (July 2017). "Forecasting Stock Prices from the Limit Order Book Using Convolutional Neural Networks". 2017 IEEE 19th Conference on Business Informatics (CBI). Thessaloniki, Greece: IEEE: 7–12. doi:10.1109/CBI.2017.23. ISBN 978-1-5386-3035-8. S2CID 4950757.

- ^ أ ب ت Fukushima, K. (2007). "Neocognitron". Scholarpedia. 2 (1): 1717. Bibcode:2007SchpJ...2.1717F. doi:10.4249/scholarpedia.1717.

- ^ أ ب Hubel, D. H.; Wiesel, T. N. (1968-03-01). "Receptive fields and functional architecture of monkey striate cortex". The Journal of Physiology. 195 (1): 215–243. doi:10.1113/jphysiol.1968.sp008455. ISSN 0022-3751. PMC 1557912. PMID 4966457.

- ^ أ ب Fukushima, Kunihiko (1980). "Neocognitron: A Self-organizing Neural Network Model for a Mechanism of Pattern Recognition Unaffected by Shift in Position" (PDF). Biological Cybernetics. 36 (4): 193–202. doi:10.1007/BF00344251. PMID 7370364. S2CID 206775608. Retrieved 16 November 2013.

- ^ أ ب Matusugu, Masakazu; Katsuhiko Mori; Yusuke Mitari; Yuji Kaneda (2003). "Subject independent facial expression recognition with robust face detection using a convolutional neural network" (PDF). Neural Networks. 16 (5): 555–559. doi:10.1016/S0893-6080(03)00115-1. PMID 12850007. Retrieved 17 November 2013.

- ^ Ian Goodfellow and Yoshua Bengio and Aaron Courville (2016). Deep Learning. MIT Press. p. 326.

- ^ "Convolutional Neural Networks (LeNet) – DeepLearning 0.1 documentation". DeepLearning 0.1. LISA Lab. Retrieved 31 August 2013.

- ^ Habibi, Aghdam, Hamed (2017-05-30). Guide to convolutional neural networks : a practical application to traffic-sign detection and classification. Heravi, Elnaz Jahani. Cham, Switzerland. ISBN 9783319575490. OCLC 987790957.

{{cite book}}: CS1 maint: location missing publisher (link) CS1 maint: multiple names: authors list (link) - ^ Venkatesan, Ragav; Li, Baoxin (2017-10-23). Convolutional Neural Networks in Visual Computing: A Concise Guide (in الإنجليزية). CRC Press. ISBN 978-1-351-65032-8.

- ^ Balas, Valentina E.; Kumar, Raghvendra; Srivastava, Rajshree (2019-11-19). Recent Trends and Advances in Artificial Intelligence and Internet of Things (in الإنجليزية). Springer Nature. ISBN 978-3-030-32644-9.

- ^ أ ب ت Ciresan, Dan; Ueli Meier; Jonathan Masci; Luca M. Gambardella; Jurgen Schmidhuber (2011). "Flexible, High Performance Convolutional Neural Networks for Image Classification" (PDF). Proceedings of the Twenty-Second International Joint Conference on Artificial Intelligence-Volume Volume Two. 2: 1237–1242. Retrieved 17 November 2013.

- ^ Krizhevsky, Alex. "ImageNet Classification with Deep Convolutional Neural Networks" (PDF). Retrieved 17 November 2013.

- ^ أ ب (November 1990) "A Neural Network for Speaker-Independent Isolated Word Recognition" in First International Conference on Spoken Language Processing (ICSLP 90)..

- ^ أ ب ت ث Ciresan, Dan; Meier, Ueli; Schmidhuber, Jürgen (June 2012). Multi-column deep neural networks for image classification. New York, NY: Institute of Electrical and Electronics Engineers (IEEE). pp. 3642–3649. arXiv:1202.2745. CiteSeerX 10.1.1.300.3283. doi:10.1109/CVPR.2012.6248110. ISBN 978-1-4673-1226-4. OCLC 812295155. S2CID 2161592.

{{cite book}}:|journal=ignored (help) - ^ LeCun, Yann. "LeNet-5, convolutional neural networks". Retrieved 16 November 2013.

- ^ Mahapattanakul, Puttatida (November 11, 2019). "From Human Vision to Computer Vision — Convolutional Neural Network(Part3/4)". Medium.

- ^ أ ب Hubel, DH; Wiesel, TN (October 1959). "Receptive fields of single neurones in the cat's striate cortex". J. Physiol. 148 (3): 574–91. doi:10.1113/jphysiol.1959.sp006308. PMC 1363130. PMID 14403679.

- ^ David H. Hubel and Torsten N. Wiesel (2005). Brain and visual perception: the story of a 25-year collaboration. Oxford University Press US. p. 106. ISBN 978-0-19-517618-6.

- ^ LeCun, Yann; Bengio, Yoshua; Hinton, Geoffrey (2015). "Deep learning". Nature. 521 (7553): 436–444. Bibcode:2015Natur.521..436L. doi:10.1038/nature14539. PMID 26017442. S2CID 3074096.

- ^ Weng, J; Ahuja, N; Huang, TS (1993). "Learning recognition and segmentation of 3-D objects from 2-D images". Proc. 4th International Conf. Computer Vision: 121–128. doi:10.1109/ICCV.1993.378228. ISBN 0-8186-3870-2. S2CID 8619176.

- ^ أ ب ت Schmidhuber, Jürgen (2015). "Deep Learning". Scholarpedia. 10 (11): 1527–54. CiteSeerX 10.1.1.76.1541. doi:10.1162/neco.2006.18.7.1527. PMID 16764513. S2CID 2309950.

- ^ Homma, Toshiteru; Les Atlas; Robert Marks II (1988). "An Artificial Neural Network for Spatio-Temporal Bipolar Patters: Application to Phoneme Classification" (PDF). Advances in Neural Information Processing Systems. 1: 31–40.

- ^ أ ب (December 1987) "Phoneme Recognition Using Time-Delay Neural Networks" in Meeting of the Institute of Electrical, Information and Communication Engineers (IEICE)..

- ^ أ ب Alexander Waibel et al., Phoneme Recognition Using Time-Delay Neural Networks IEEE Transactions on Acoustics, Speech, and Signal Processing, Volume 37, No. 3, pp. 328. - 339 March 1989.

- ^ LeCun, Yann; Bengio, Yoshua (1995). "Convolutional networks for images, speech, and time series". In Arbib, Michael A. (ed.). The handbook of brain theory and neural networks (Second ed.). The MIT press. pp. 276–278.

- ^ John B. Hampshire and Alexander Waibel, Connectionist Architectures for Multi-Speaker Phoneme Recognition, Advances in Neural Information Processing Systems, 1990, Morgan Kaufmann.

- ^ أ ب Le Callet, Patrick; Christian Viard-Gaudin; Dominique Barba (2006). "A Convolutional Neural Network Approach for Objective Video Quality Assessment" (PDF). IEEE Transactions on Neural Networks. 17 (5): 1316–1327. doi:10.1109/TNN.2006.879766. PMID 17001990. S2CID 221185563. Retrieved 17 November 2013.

- ^ (March 2018) "A Study on Data Augmentation of Reverberant Speech for Robust Speech Recognition" in The 42nd IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP 2017)..

- ^ Denker, J S , Gardner, W R., Graf, H. P, Henderson, D, Howard, R E, Hubbard, W, Jackel, L D , BaIrd, H S, and Guyon (1989) Neural network recognizer for hand-written zip code digits, AT&T Bell Laboratories

- ^ أ ب Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, L. D. Jackel, Backpropagation Applied to Handwritten Zip Code Recognition; AT&T Bell Laboratories

- ^ LeCun, Yann; Léon Bottou; Yoshua Bengio; Patrick Haffner (1998). "Gradient-based learning applied to document recognition" (PDF). Proceedings of the IEEE. 86 (11): 2278–2324. CiteSeerX 10.1.1.32.9552. doi:10.1109/5.726791. Retrieved October 7, 2016.

- ^ Zhang, Wei (1991). "Error Back Propagation with Minimum-Entropy Weights: A Technique for Better Generalization of 2-D Shift-Invariant NNs". Proceedings of the International Joint Conference on Neural Networks.

- ^ Zhang, Wei (1991). "Image processing of human corneal endothelium based on a learning network". Applied Optics. 30 (29): 4211–7. Bibcode:1991ApOpt..30.4211Z. doi:10.1364/AO.30.004211. PMID 20706526.

- ^ Zhang, Wei (1994). "Computerized detection of clustered microcalcifications in digital mammograms using a shift-invariant artificial neural network". Medical Physics. 21 (4): 517–24. Bibcode:1994MedPh..21..517Z. doi:10.1118/1.597177. PMID 8058017.

- ^ Daniel Graupe, Ruey Wen Liu, George S Moschytz."Applications of neural networks to medical signal processing". In Proc. 27th IEEE Decision and Control Conf., pp. 343–347, 1988.

- ^ Daniel Graupe, Boris Vern, G. Gruener, Aaron Field, and Qiu Huang. "Decomposition of surface EMG signals into single fiber action potentials by means of neural network". Proc. IEEE International Symp. on Circuits and Systems, pp. 1008–1011, 1989.

- ^ Qiu Huang, Daniel Graupe, Yi Fang Huang, Ruey Wen Liu."Identification of firing patterns of neuronal signals." In Proc. 28th IEEE Decision and Control Conf., pp. 266–271, 1989.

- ^ Behnke, Sven (2003). Hierarchical Neural Networks for Image Interpretation (PDF). Lecture Notes in Computer Science. Vol. 2766. Springer. doi:10.1007/b11963. ISBN 978-3-540-40722-5. S2CID 1304548.

- ^ Oh, KS; Jung, K (2004). "GPU implementation of neural networks". Pattern Recognition. 37 (6): 1311–1314. doi:10.1016/j.patcog.2004.01.013.

- ^ Dave Steinkraus; Patrice Simard; Ian Buck (2005). "Using GPUs for Machine Learning Algorithms". 12th International Conference on Document Analysis and Recognition (ICDAR 2005). pp. 1115–1119.

{{cite book}}:|archive-date=requires|archive-url=(help) - ^ Kumar Chellapilla; Sid Puri; Patrice Simard (2006). "High Performance Convolutional Neural Networks for Document Processing". In Lorette, Guy (ed.). Tenth International Workshop on Frontiers in Handwriting Recognition. Suvisoft.

{{cite book}}:|archive-date=requires|archive-url=(help) - ^ Hinton, GE; Osindero, S; Teh, YW (Jul 2006). "A fast learning algorithm for deep belief nets". Neural Computation. 18 (7): 1527–54. CiteSeerX 10.1.1.76.1541. doi:10.1162/neco.2006.18.7.1527. PMID 16764513. S2CID 2309950.

- ^ Bengio, Yoshua; Lamblin, Pascal; Popovici, Dan; Larochelle, Hugo (2007). "Greedy Layer-Wise Training of Deep Networks" (PDF). Advances in Neural Information Processing Systems: 153–160.

- ^ Ranzato, MarcAurelio; Poultney, Christopher; Chopra, Sumit; LeCun, Yann (2007). "Efficient Learning of Sparse Representations with an Energy-Based Model" (PDF). Advances in Neural Information Processing Systems.

- ^ Raina, R; Madhavan, A; Ng, Andrew (2009). "Large-scale deep unsupervised learning using graphics processors" (PDF). ICML: 873–880.

- ^ Ciresan, Dan; Meier, Ueli; Gambardella, Luca; Schmidhuber, Jürgen (2010). "Deep big simple neural nets for handwritten digit recognition". Neural Computation. 22 (12): 3207–3220. arXiv:1003.0358. doi:10.1162/NECO_a_00052. PMID 20858131. S2CID 1918673.

- ^ "IJCNN 2011 Competition result table". OFFICIAL IJCNN2011 COMPETITION (in الإنجليزية الأمريكية). 2010. Retrieved 2019-01-14.

- ^ Schmidhuber, Jürgen (17 March 2017). "History of computer vision contests won by deep CNNs on GPU" (in الإنجليزية الأمريكية). Retrieved 14 January 2019.

- ^ أ ب Krizhevsky, Alex; Sutskever, Ilya; Hinton, Geoffrey E. (2017-05-24). "ImageNet classification with deep convolutional neural networks" (PDF). Communications of the ACM. 60 (6): 84–90. doi:10.1145/3065386. ISSN 0001-0782. S2CID 195908774.

- ^ He, Kaiming; Zhang, Xiangyu; Ren, Shaoqing; Sun, Jian (2016). "Deep Residual Learning for Image Recognition" (PDF). 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR): 770–778. arXiv:1512.03385. doi:10.1109/CVPR.2016.90. ISBN 978-1-4673-8851-1. S2CID 206594692.

- ^

Viebke, Andre; Pllana, Sabri (2015). "The Potential of the Intel (R) Xeon Phi for Supervised Deep Learning". 2015 IEEE 17th International Conference on High Performance Computing and Communications, 2015 IEEE 7th International Symposium on Cyberspace Safety and Security, and 2015 IEEE 12th International Conference on Embedded Software and Systems. IEEE 2015. pp. 758–765. doi:10.1109/HPCC-CSS-ICESS.2015.45. ISBN 978-1-4799-8937-9. S2CID 15411954.

{{cite book}}:|website=ignored (help) - ^ Viebke, Andre; Memeti, Suejb; Pllana, Sabri; Abraham, Ajith (2019). "CHAOS: a parallelization scheme for training convolutional neural networks on Intel Xeon Phi". The Journal of Supercomputing. 75 (1): 197–227. arXiv:1702.07908. doi:10.1007/s11227-017-1994-x. S2CID 14135321.

- ^ Hinton, Geoffrey (2012). "ImageNet Classification with Deep Convolutional Neural Networks". NIPS'12: Proceedings of the 25th International Conference on Neural Information Processing Systems - Volume 1. 1: 1097–1105 – via ACM.

- ^ أ ب ت ث ج Azulay, Aharon; Weiss, Yair (2019). "Why do deep convolutional networks generalize so poorly to small image transformations?". Journal of Machine Learning Research. 20 (184): 1–25. ISSN 1533-7928.

- ^ أ ب Géron, Aurélien (2019). Hands-on Machine Learning with Scikit-Learn, Keras, and TensorFlow. Sebastopol, CA: O'Reilly Media. ISBN 978-1-492-03264-9., pp. 448

- ^ "CS231n Convolutional Neural Networks for Visual Recognition". cs231n.github.io. Retrieved 2017-04-25.

- ^ أ ب (2010) "Evaluation of Pooling Operations in Convolutional Architectures for Object Recognition".: 92–101, Thessaloniki, Greece: Springer.

- ^ Graham, Benjamin (2014-12-18). "Fractional Max-Pooling". arXiv:1412.6071 [cs.CV].

- ^ Springenberg, Jost Tobias; Dosovitskiy, Alexey; Brox, Thomas; Riedmiller, Martin (2014-12-21). "Striving for Simplicity: The All Convolutional Net". arXiv:1412.6806 [cs.LG].

- ^ Grel, Tomasz (2017-02-28). "Region of interest pooling explained". deepsense.io (in الإنجليزية).

- ^ Girshick, Ross (2015-09-27). "Fast R-CNN". arXiv:1504.08083 [cs.CV].

- ^ Romanuke, Vadim (2017). "Appropriate number and allocation of ReLUs in convolutional neural networks". Research Bulletin of NTUU "Kyiv Polytechnic Institute". 1: 69–78. doi:10.20535/1810-0546.2017.1.88156.

- ^ Krizhevsky, A.; Sutskever, I.; Hinton, G. E. (2012). "Imagenet classification with deep convolutional neural networks" (PDF). Advances in Neural Information Processing Systems. 1: 1097–1105.

- ^ Deshpande, Adit. "The 9 Deep Learning Papers You Need To Know About (Understanding CNNs Part 3)". adeshpande3.github.io. Retrieved 2018-12-04.

- ^ Myburgh, Johannes C.; Mouton, Coenraad; Davel, Marelie H. (2020). Gerber, Aurona (ed.). "Tracking Translation Invariance in CNNs". Artificial Intelligence Research. Communications in Computer and Information Science (in الإنجليزية). Cham: Springer International Publishing. 1342: 282–295. arXiv:2104.05997. doi:10.1007/978-3-030-66151-9_18. ISBN 978-3-030-66151-9. S2CID 233219976.

- ^ Richard, Zhang (2019-04-25). Making Convolutional Networks Shift-Invariant Again. OCLC 1106340711.

- ^ Jadeberg, Simonyan, Zisserman, Kavukcuoglu, Max, Karen, Andrew, Koray (2015). "Spatial Transformer Networks" (PDF). Advances in Neural Information Processing Systems. 28 – via NIPS.

{{cite journal}}: CS1 maint: multiple names: authors list (link) - ^ E, Sabour, Sara Frosst, Nicholas Hinton, Geoffrey (2017-10-26). Dynamic Routing Between Capsules. OCLC 1106278545.

{{cite book}}: CS1 maint: multiple names: authors list (link) - ^ Srivastava, Nitish; C. Geoffrey Hinton; Alex Krizhevsky; Ilya Sutskever; Ruslan Salakhutdinov (2014). "Dropout: A Simple Way to Prevent Neural Networks from overfitting" (PDF). Journal of Machine Learning Research. 15 (1): 1929–1958.

- ^ Carlos E. Perez. "A Pattern Language for Deep Learning".

- ^ "Regularization of Neural Networks using DropConnect | ICML 2013 | JMLR W&CP". jmlr.org: 1058–1066. 2013-02-13. Retrieved 2015-12-17.

- ^ Zeiler, Matthew D.; Fergus, Rob (2013-01-15). "Stochastic Pooling for Regularization of Deep Convolutional Neural Networks". arXiv:1301.3557 [cs.LG].

- ^ أ ب Platt, John; Steinkraus, Dave; Simard, Patrice Y. (August 2003). "Best Practices for Convolutional Neural Networks Applied to Visual Document Analysis – Microsoft Research". Microsoft Research. Retrieved 2015-12-17.

- ^ Hinton, Geoffrey E.; Srivastava, Nitish; Krizhevsky, Alex; Sutskever, Ilya; Salakhutdinov, Ruslan R. (2012). "Improving neural networks by preventing co-adaptation of feature detectors". arXiv:1207.0580 [cs.NE].

- ^ "Dropout: A Simple Way to Prevent Neural Networks from Overfitting". jmlr.org. Retrieved 2015-12-17.

- ^ Hinton, Geoffrey (1979). "Some demonstrations of the effects of structural descriptions in mental imagery". Cognitive Science. 3 (3): 231–250. doi:10.1016/s0364-0213(79)80008-7.

- ^ Rock, Irvin. "The frame of reference." The legacy of Solomon Asch: Essays in cognition and social psychology (1990): 243–268.

- ^ J. Hinton, Coursera lectures on Neural Networks, 2012, Url: https://www.coursera.org/learn/neural-networks Archived 2016-12-31 at the Wayback Machine

- ^ Dave Gershgorn (18 June 2018). "The inside story of how AI got good enough to dominate Silicon Valley". Quartz. Retrieved 5 October 2018.

- ^ Lawrence, Steve; C. Lee Giles; Ah Chung Tsoi; Andrew D. Back (1997). "Face Recognition: A Convolutional Neural Network Approach". IEEE Transactions on Neural Networks. 8 (1): 98–113. CiteSeerX 10.1.1.92.5813. doi:10.1109/72.554195. PMID 18255614.

- ^ "ImageNet Large Scale Visual Recognition Competition 2014 (ILSVRC2014)". Retrieved 30 January 2016.

- ^ Szegedy, Christian; Liu, Wei; Jia, Yangqing; Sermanet, Pierre; Reed, Scott; Anguelov, Dragomir; Erhan, Dumitru; Vanhoucke, Vincent; Rabinovich, Andrew (2014). "Going Deeper with Convolutions". Computing Research Repository. arXiv:1409.4842. Bibcode:2014arXiv1409.4842S.

- ^ Russakovsky, Olga; Deng, Jia; Su, Hao; Krause, Jonathan; Satheesh, Sanjeev; Ma, Sean; Huang, Zhiheng; Karpathy, Andrej; Khosla, Aditya; Bernstein, Michael; Berg, Alexander C.; Fei-Fei, Li (2014). "Image Net Large Scale Visual Recognition Challenge". arXiv:1409.0575 [cs.CV].

- ^ "The Face Detection Algorithm Set To Revolutionize Image Search". Technology Review. February 16, 2015. Retrieved 27 October 2017.

- ^ Baccouche, Moez; Mamalet, Franck; Wolf, Christian; Garcia, Christophe; Baskurt, Atilla (2011-11-16). "Sequential Deep Learning for Human Action Recognition". In Salah, Albert Ali; Lepri, Bruno (eds.). Human Behavior Unterstanding. Lecture Notes in Computer Science. Vol. 7065. Springer Berlin Heidelberg. pp. 29–39. CiteSeerX 10.1.1.385.4740. doi:10.1007/978-3-642-25446-8_4. ISBN 978-3-642-25445-1.

- ^ Ji, Shuiwang; Xu, Wei; Yang, Ming; Yu, Kai (2013-01-01). "3D Convolutional Neural Networks for Human Action Recognition". IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (1): 221–231. CiteSeerX 10.1.1.169.4046. doi:10.1109/TPAMI.2012.59. ISSN 0162-8828. PMID 22392705. S2CID 1923924.

- ^ قالب:Cite arxiv

- ^ Karpathy, Andrej, et al. "Large-scale video classification with convolutional neural networks." IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2014.

- ^ Simonyan, Karen; Zisserman, Andrew (2014). "Two-Stream Convolutional Networks for Action Recognition in Videos". arXiv:1406.2199 [cs.CV]. (2014).

- ^ Wang, Le; Duan, Xuhuan; Zhang, Qilin; Niu, Zhenxing; Hua, Gang; Zheng, Nanning (2018-05-22). "Segment-Tube: Spatio-Temporal Action Localization in Untrimmed Videos with Per-Frame Segmentation" (PDF). Sensors. 18 (5): 1657. doi:10.3390/s18051657. ISSN 1424-8220. PMC 5982167. PMID 29789447.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ (2018) "Joint Spatio-Temporal Action Localization in Untrimmed Videos with Per-Frame Segmentation"., 25th IEEE International Conference on Image Processing (ICIP). doi:10.1109/icip.2018.8451692.

- ^ Taylor, Graham W.; Fergus, Rob; LeCun, Yann; Bregler, Christoph (2010-01-01). Convolutional Learning of Spatio-temporal Features. ECCV'10. Berlin, Heidelberg: Springer-Verlag. pp. 140–153. ISBN 978-3-642-15566-6.

{{cite book}}:|journal=ignored (help) - ^ Le, Q. V.; Zou, W. Y.; Yeung, S. Y.; Ng, A. Y. (2011-01-01). Learning Hierarchical Invariant Spatio-temporal Features for Action Recognition with Independent Subspace Analysis. CVPR '11. Washington, DC, USA: IEEE Computer Society. pp. 3361–3368. CiteSeerX 10.1.1.294.5948. doi:10.1109/CVPR.2011.5995496. ISBN 978-1-4577-0394-2. S2CID 6006618.

{{cite book}}:|journal=ignored (help) - ^ Grefenstette, Edward; Blunsom, Phil; de Freitas, Nando; Hermann, Karl Moritz (2014-04-29). "A Deep Architecture for Semantic Parsing". arXiv:1404.7296 [cs.CL].

- ^ Mesnil, Gregoire; Deng, Li; Gao, Jianfeng; He, Xiaodong; Shen, Yelong (April 2014). "Learning Semantic Representations Using Convolutional Neural Networks for Web Search – Microsoft Research". Microsoft Research. Retrieved 2015-12-17.

- ^ Kalchbrenner, Nal; Grefenstette, Edward; Blunsom, Phil (2014-04-08). "A Convolutional Neural Network for Modelling Sentences". arXiv:1404.2188 [cs.CL].

- ^ Kim, Yoon (2014-08-25). "Convolutional Neural Networks for Sentence Classification". arXiv:1408.5882 [cs.CL].

- ^ Collobert, Ronan, and Jason Weston. "A unified architecture for natural language processing: Deep neural networks with multitask learning."Proceedings of the 25th international conference on Machine learning. ACM, 2008.

- ^ Collobert, Ronan; Weston, Jason; Bottou, Leon; Karlen, Michael; Kavukcuoglu, Koray; Kuksa, Pavel (2011-03-02). "Natural Language Processing (almost) from Scratch". arXiv:1103.0398 [cs.LG].

- ^ Ren, Hansheng; Xu, Bixiong; Wang, Yujing; Yi, Chao; Huang, Congrui; Kou, Xiaoyu; Xing, Tony; Yang, Mao; Tong, Jie; Zhang, Qi (2019). "Time-Series Anomaly Detection Service at Microsoft | Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining" (in الإنجليزية). arXiv:1906.03821. doi:10.1145/3292500.3330680. S2CID 182952311.

{{cite journal}}: Cite journal requires|journal=(help) - ^ Wallach, Izhar; Dzamba, Michael; Heifets, Abraham (2015-10-09). "AtomNet: A Deep Convolutional Neural Network for Bioactivity Prediction in Structure-based Drug Discovery". arXiv:1510.02855 [cs.LG].

- ^ Yosinski, Jason; Clune, Jeff; Nguyen, Anh; Fuchs, Thomas; Lipson, Hod (2015-06-22). "Understanding Neural Networks Through Deep Visualization". arXiv:1506.06579 [cs.CV].

- ^ "Toronto startup has a faster way to discover effective medicines". The Globe and Mail. Retrieved 2015-11-09.

- ^ "Startup Harnesses Supercomputers to Seek Cures". KQED Future of You (in الإنجليزية الأمريكية). 2015-05-27. Retrieved 2015-11-09.

- ^ Tim Pyrkov; Konstantin Slipensky; Mikhail Barg; Alexey Kondrashin; Boris Zhurov; Alexander Zenin; Mikhail Pyatnitskiy; Leonid Menshikov; Sergei Markov; Peter O. Fedichev (2018). "Extracting biological age from biomedical data via deep learning: too much of a good thing?". Scientific Reports. 8 (1): 5210. Bibcode:2018NatSR...8.5210P. doi:10.1038/s41598-018-23534-9. PMC 5980076. PMID 29581467.

- ^ Chellapilla, K; Fogel, DB (1999). "Evolving neural networks to play checkers without relying on expert knowledge". IEEE Trans Neural Netw. 10 (6): 1382–91. doi:10.1109/72.809083. PMID 18252639.

- ^ Chellapilla, K.; Fogel, D.B. (2001). "Evolving an expert checkers playing program without using human expertise". IEEE Transactions on Evolutionary Computation. 5 (4): 422–428. doi:10.1109/4235.942536.

- ^ Fogel, David (2001). Blondie24: Playing at the Edge of AI. San Francisco, CA: Morgan Kaufmann. ISBN 978-1558607835.

- ^ Clark, Christopher; Storkey, Amos (2014). "Teaching Deep Convolutional Neural Networks to Play Go". arXiv:1412.3409 [cs.AI].

- ^ Maddison, Chris J.; Huang, Aja; Sutskever, Ilya; Silver, David (2014). "Move Evaluation in Go Using Deep Convolutional Neural Networks". arXiv:1412.6564 [cs.LG].

- ^ "AlphaGo – Google DeepMind". Archived from the original on 30 January 2016. Retrieved 30 January 2016.

- ^ Bai, Shaojie; Kolter, J. Zico; Koltun, Vladlen (2018-04-19). "An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling". arXiv:1803.01271 [cs.LG].

- ^ Yu, Fisher; Koltun, Vladlen (2016-04-30). "Multi-Scale Context Aggregation by Dilated Convolutions". arXiv:1511.07122 [cs.CV].

- ^ Borovykh, Anastasia; Bohte, Sander; Oosterlee, Cornelis W. (2018-09-17). "Conditional Time Series Forecasting with Convolutional Neural Networks". arXiv:1703.04691 [stat.ML].

- ^ Mittelman, Roni (2015-08-03). "Time-series modeling with undecimated fully convolutional neural networks". arXiv:1508.00317 [stat.ML].

- ^ Chen, Yitian; Kang, Yanfei; Chen, Yixiong; Wang, Zizhuo (2019-06-11). "Probabilistic Forecasting with Temporal Convolutional Neural Network". arXiv:1906.04397 [stat.ML].

- ^ Zhao, Bendong; Lu, Huanzhang; Chen, Shangfeng; Liu, Junliang; Wu, Dongya (2017-02-01). "Convolutional neural networks for time series classi". Journal of Systems Engineering and Electronics. 28 (1): 162–169. doi:10.21629/JSEE.2017.01.18.

- ^ Petneházi, Gábor (2019-08-21). "QCNN: Quantile Convolutional Neural Network". arXiv:1908.07978 [cs.LG].

- ^ Hubert Mara (2019-06-07) (in de), HeiCuBeDa Hilprecht – Heidelberg Cuneiform Benchmark Dataset for the Hilprecht Collection, heiDATA – institutional repository for research data of Heidelberg University, doi:

- ^ Hubert Mara and Bartosz Bogacz (2019), "Breaking the Code on Broken Tablets: The Learning Challenge for Annotated Cuneiform Script in Normalized 2D and 3D Datasets" (in de), Proceedings of the 15th International Conference on Document Analysis and Recognition (ICDAR) (Sydney, Australien): 148–153, doi:, ISBN 978-1-7281-3014-9

- ^ Bogacz, Bartosz; Mara, Hubert (2020), "Period Classification of 3D Cuneiform Tablets with Geometric Neural Networks", Proceedings of the 17th International Conference on Frontiers of Handwriting Recognition (ICFHR) (Dortmund, Germany)

- ^ Presentation of the ICFHR paper on Period Classification of 3D Cuneiform Tablets with Geometric Neural Networks at YouTube

- ^ Durjoy Sen Maitra; Ujjwal Bhattacharya; S.K. Parui, "CNN based common approach to handwritten character recognition of multiple scripts," in Document Analysis and Recognition (ICDAR), 2015 13th International Conference on, vol., no., pp.1021–1025, 23–26 Aug. 2015

- ^ "NIPS 2017". Interpretable ML Symposium. 2017-10-20. Retrieved 2018-09-12.

- ^ Zang, Jinliang; Wang, Le; Liu, Ziyi; Zhang, Qilin; Hua, Gang; Zheng, Nanning (2018). "Attention-Based Temporal Weighted Convolutional Neural Network for Action Recognition". IFIP Advances in Information and Communication Technology. Cham: Springer International Publishing. pp. 97–108. arXiv:1803.07179. doi:10.1007/978-3-319-92007-8_9. ISBN 978-3-319-92006-1. ISSN 1868-4238. S2CID 4058889.

- ^ Wang, Le; Zang, Jinliang; Zhang, Qilin; Niu, Zhenxing; Hua, Gang; Zheng, Nanning (2018-06-21). "Action Recognition by an Attention-Aware Temporal Weighted Convolutional Neural Network" (PDF). Sensors. 18 (7): 1979. doi:10.3390/s18071979. ISSN 1424-8220. PMC 6069475. PMID 29933555.